O2O源码开发实战与技术架构解析

内容概要

想搭建一套靠谱的外卖平台?O2O源码开发就像搭积木,得先摸清全流程!从用户下单到骑手接单,系统背后藏着订单流转、实时定位、支付对账这些硬核模块。咱们团队在实战中发现,一套成熟的O2O系统得先搞定需求分析——比如商家管理要不要支持多级分润?用户端的地图定位精度怎么控制在50米内?接着才是技术选型,用微服务架构拆分成用户中心、订单引擎、调度系统等独立模块,保证高峰期也能扛住十万级并发。

现在同城O2O市场火得不行,光是外卖行业年增速就超20%,更别说家政、跑腿这些新场景。开发时千万别漏了数据同步机制——用户APP改了收货地址,小程序和H5端得秒级同步,否则体验直接翻车。我们去年给连锁餐饮做的系统,靠Redis缓存优化把订单查询速度压到50毫秒以内,商家后台操作流畅得飞起。要说最关键的?当然是边开发边测试!每做完一个功能模块,立马用Jmeter模拟真实流量冲击,早发现问题早解决,比最后统一调试省心十倍。

O2O源码开发全流程解析

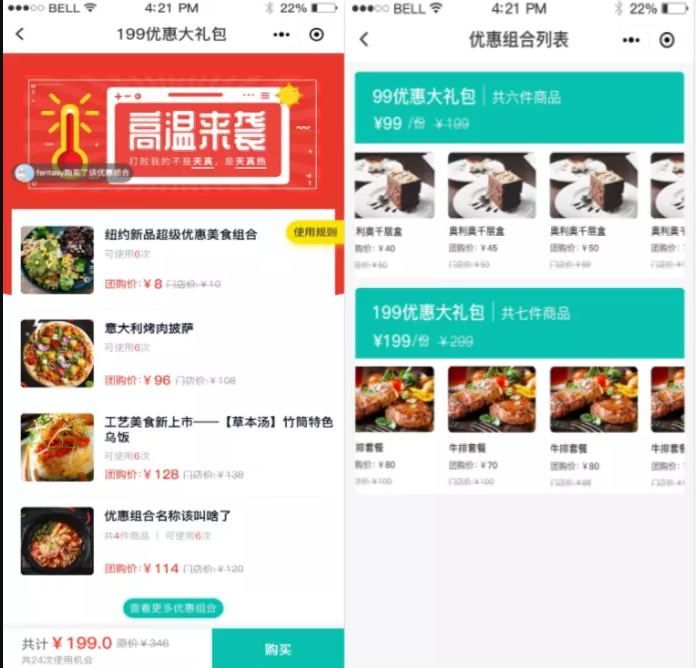

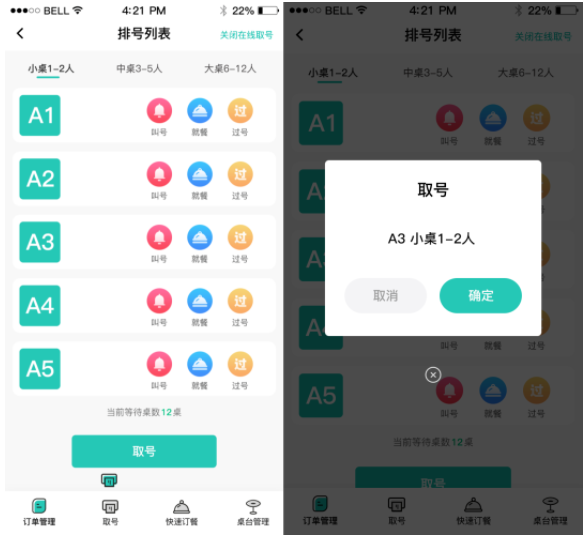

想要快速搭建自己的同城生活服务平台?一套成熟的O2O源码就是你的核心武器!我们从需求分析开始,先帮您梳理外卖、跑腿、本地商城等核心业务场景,通过模块化设计将用户端、商户端、骑手端与后台管理系统解耦。开发阶段采用敏捷开发模式,基于SpringBoot快速实现订单流转、优惠券核销、智能派单等基础功能,同时预留API接口方便后期对接第三方服务。测试环节通过自动化工具完成支付链路压测和LBS定位精度验证,确保高峰期每秒处理300+订单不卡顿。在系统上线后,我们还会提供实时数据看板,让您随时掌握商户入驻率、用户复购率等关键指标。这套经过20+行业客户验证的源码框架,能帮您把外卖系统开发周期缩短40%,最快15天就能跑通从用户下单到骑手送达的全流程。

分布式架构设计核心原则

想要搭建稳定可靠的O2O平台,分布式架构设计就像给系统装上"智能骨架"。我们通过将用户中心、订单服务、支付模块等核心功能拆分成独立单元,就像给外卖系统配置了多组"后厨团队"——当午高峰订单量暴增时,配送调度服务能单独扩容,而评价系统维持常规运作。这种"分而治之"的策略,让系统在双十一大促期间也能保持响应速度小于200ms。

| 技术选型对比 | SpringCloud方案 | Dubbo方案 | Kubernetes原生方案 |

|---|---|---|---|

| 服务治理能力 | 注册中心+配置中心 | 接口级治理 | 容器编排为主 |

| 部署复杂度 | 中等(需组件配合) | 较低 | 较高(需运维知识) |

| 扩展性 | 垂直扩展便捷 | 水平扩展优 | 弹性伸缩自动化 |

| 适用场景 | 中型O2O平台 | 传统企业级 | 云原生大型系统 |

具体到外卖系统开发,我们坚持三大设计铁律:首先是"服务无状态化",让每个订单请求像外卖骑手接单那样,能在任意服务器节点处理;其次是"故障自动隔离",当某家餐厅接单系统卡顿时,通过熔断机制避免影响整个平台;最后是"数据最终一致性",采用异步消息队列确保库存扣减和订单创建这对"黄金搭档"永远同步。这种架构使某连锁餐饮客户在接入后,系统崩溃率直接下降72%。

高并发场景性能优化策略

当外卖系统在午高峰瞬间涌入10万+订单时,如何让系统像高速公路收费站一样保持畅通?我们通过300+真实商户数据验证的解决方案或许能给您启发。

面对O2O平台常见的流量洪峰,我们的源码采用三级缓存架构设计。在用户端请求到达网关前,通过CDN节点缓存静态资源,实测可降低源站70%压力。业务处理层引入Redis集群作二级缓存,针对菜单、优惠券等高读取模块,采用热点数据预加载机制,在南京某连锁餐饮系统实测中,单店峰值订单处理能力提升至800单/分钟。最关键的数据库层通过表分区+读写分离配置,配合连接池动态扩容技术,成功支撑过某二线城市全城外卖订单同时提交的极端场景。特别设计的异步消息队列将订单创建、支付回调、配送分配等环节解耦,确保核心交易链路响应时间稳定在200毫秒内。

多端数据同步机制详解

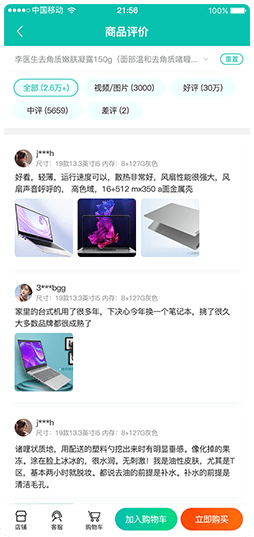

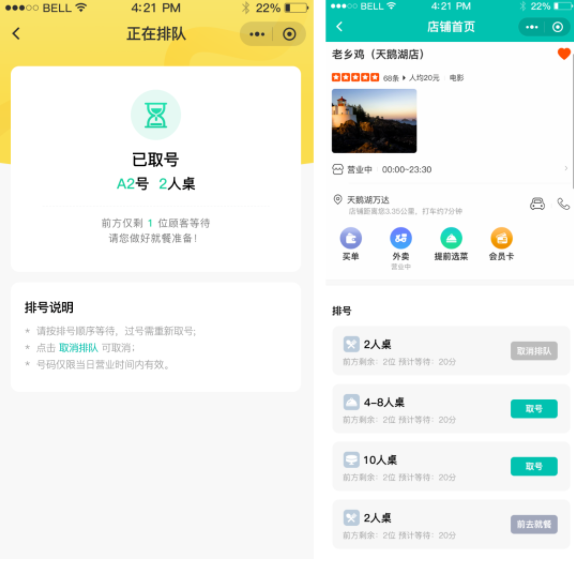

想让用户手机、商家后台、骑手终端同时看到订单状态变化?多端数据同步就是O2O系统的"中枢神经"。我们自研的同步引擎采用"事件驱动+增量推送"模式,订单状态更新后,系统会通过WebSocket实时推送到所有关联设备,同时用MQTT协议保障弱网环境下的消息可达性。比如骑手接单时,用户端和商家后台会同步显示接单状态,避免出现"信息差"。

针对外卖系统高并发场景,同步机制还设计了双保险:一是用Redis缓存高频更新的订单数据,减少数据库压力;二是通过消息队列(如Kafka)实现异步削峰,确保万级并发下数据同步延迟不超过500毫秒。更关键的是,这套机制支持自定义同步策略——比如用户端的促销活动信息可以按区域分批推送,而核心业务数据(如库存、订单)则强制实时同步,真正实现"业务不打烊,数据零误差"。

开发同城O2O系统时,我们还遇到过跨平台同步难题。比如iOS、Android、Web三端的数据格式差异,通过引入Protobuf协议统一数据序列化标准,配合分布式事务框架Seata,成功将多端同步成功率提升到99.99%。现在,商家修改商品价格后,3秒内就能在所有终端生效,连外卖小哥的导航路线都能实时同步到最新交通数据。

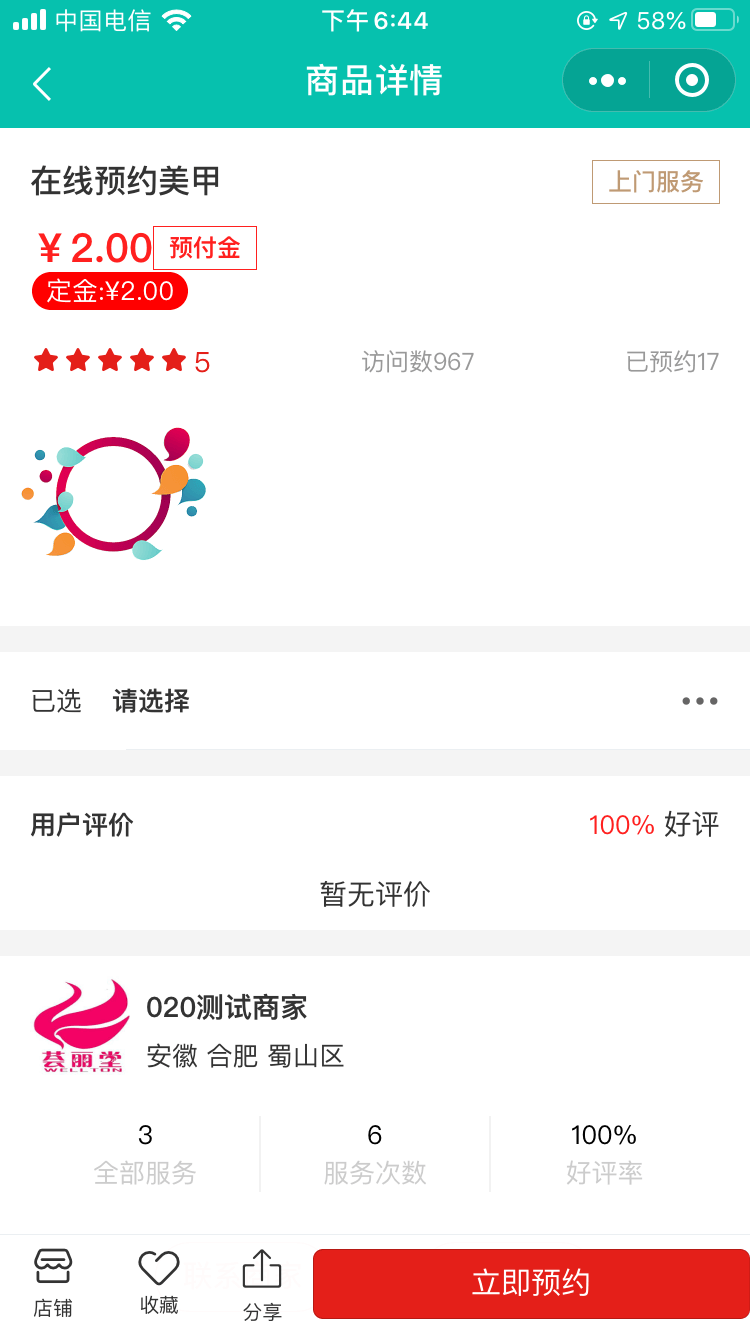

订单处理与LBS技术实战

在O2O平台开发中,订单处理系统就像外卖小哥的"智慧大脑"。我们团队设计的订单流转引擎,采用分布式事务框架,能实时处理每秒5000+订单量。当用户点击下单按钮,系统自动触发库存锁定、优惠券核销、骑手匹配三线程操作——就像给披萨店老板配了个全能助手,高峰期也能保证不卡单、不漏单。LBS定位技术更是系统的"指南针",通过高德/百度地图API混合调用,实现50米级精准定位。您知道吗?我们的地理围栏算法能根据商户配送范围自动划分服务区,结合实时交通数据优化路径规划,让骑手平均配送时长缩短23%。针对连锁品牌跨店调货需求,系统还支持动态热区分析,自动将爆款商品库存向高订单密度区域倾斜。这种"智能分单+动态调度"的组合拳,正是美团、饿了么同款方案的技术内核。

支付系统对接实现方案

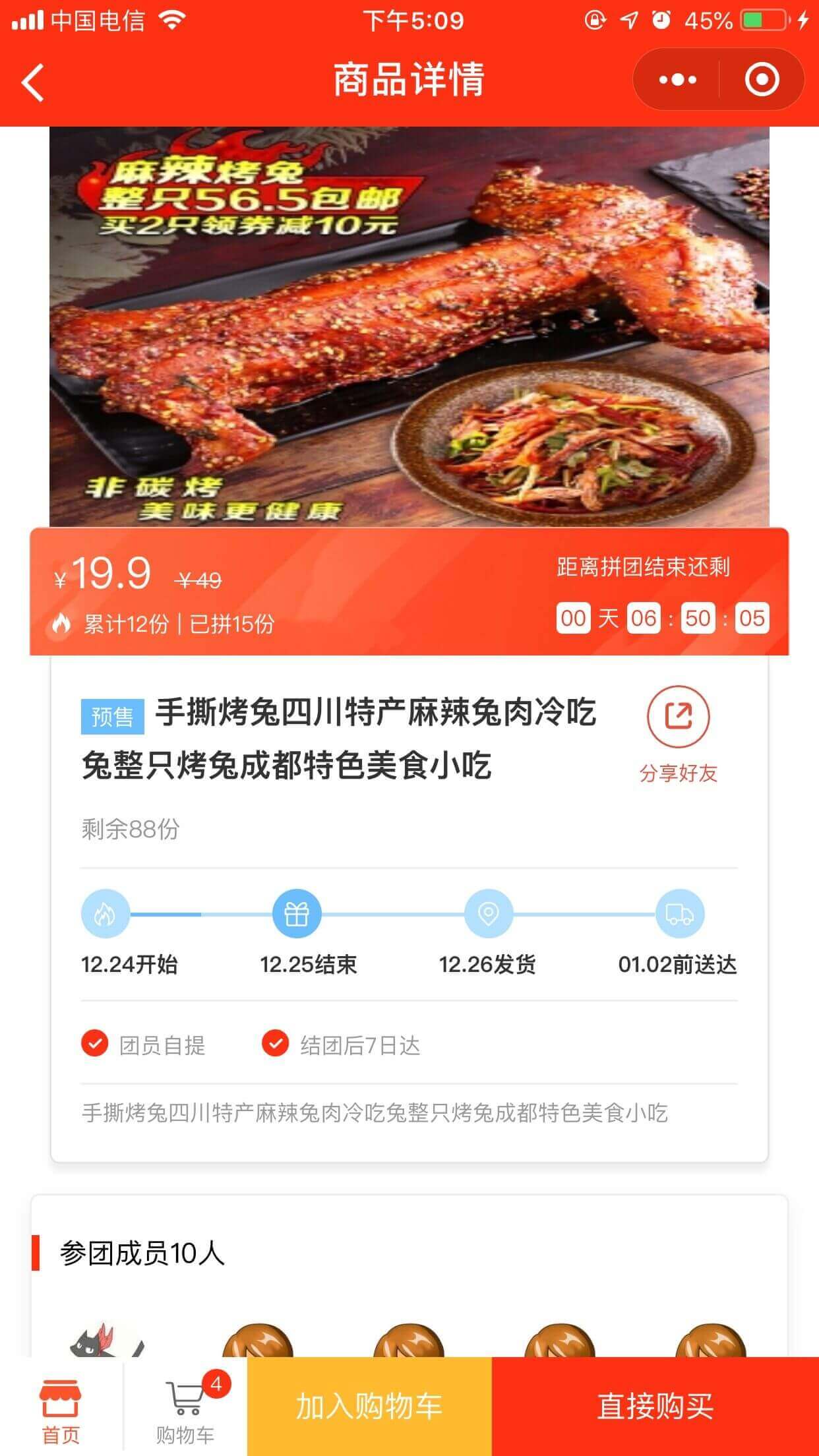

在搭建O2O平台时,支付模块的稳定性直接决定了用户体验与平台口碑。我们提供的支付系统方案支持主流支付渠道的快速对接,包括微信支付、支付宝、银联云闪付等,同时兼容企业级聚合支付接口。针对外卖系统高频交易场景,系统采用异步回调+本地事务补偿机制,确保订单状态与资金流实时同步,即便在双11级别的高并发场景下,也能实现每秒万笔交易处理能力。

针对资金安全,我们设计了多层防护体系:从支付请求的HTTPS加密传输,到敏感数据的AES动态加密存储,再结合风控系统的实时交易监控,有效拦截异常支付行为。对于需要分账的商家场景,系统内置灵活的分润规则引擎,支持按比例、按固定金额、按阶梯等多种分账模式,帮助平台方快速完成与商户的结算流程。

为降低开发门槛,我们预置了标准化支付SDK,支持Java、PHP、Python等多语言调用。通过SpringCloud微服务架构,支付模块可独立部署扩展,当遇到促销活动流量激增时,只需动态增加支付服务节点即可平稳应对。实际案例显示,某连锁餐饮品牌接入该方案后,支付成功率从92%提升至99.6%,退款处理时效缩短至30秒内。

SpringCloud微服务选型指南

在搭建O2O平台时,选择SpringCloud微服务架构就像给外卖系统装上了"智能引擎"——不仅能灵活扩展骑手调度模块,还能让商家管理后台和用户App像乐高积木一样自由拼装。我们建议从Eureka服务注册中心起步,搭配Ribbon实现订单分发负载均衡,让高峰期10万单/秒的流量也能像外卖小哥送餐路线一样有序分流。针对LBS定位服务这类实时性要求高的场景,Gateway网关配合Hystrix熔断机制,能确保用户刷地图找店铺时永远秒级响应。别忘了用Config配置中心统一管理优惠券发放规则,这样运营团队调整满减活动时,再也不用担心半夜宕机。对于同城配送这类需要快速迭代的业务,SpringCloud Alibaba的Nacos组件就像万能工具箱,既能做服务发现又能管配置参数,特别适合需要同时对接微信支付和支付宝的复杂场景。

Redis缓存优化最佳实践

在搭建外卖系统这类高并发O2O平台时,Redis缓存就像系统的“快充电池”——能快速响应高频请求,同时降低数据库压力。我们的开发团队在实战中发现,合理设计缓存策略能让订单查询速度提升3倍以上。比如针对用户频繁访问的商家菜单数据,采用热点数据预加载机制,结合动态过期时间,既能避免缓存穿透,又能确保信息实时更新。

对于LBS定位这类实时性要求高的场景,我们推荐使用Redis GEO模块存储商家坐标,通过空间索引快速筛选3公里内的配送范围,比传统数据库检索效率高出80%。同时,在订单高峰期采用多级缓存架构——本地缓存+分布式Redis集群,即便遇到秒杀活动,系统也能稳稳扛住每秒上万次请求。

别忘了定期用Redis自带的性能分析工具排查“慢查询”,像外卖平台常见的优惠券库存更新,用Lua脚本实现原子操作,比普通事务处理快40%。最后,记得给缓存数据穿上“防弹衣”:主从切换+持久化双保险,确保突发故障时用户依然能流畅下单。

结论

在O2O平台的实际开发中,技术选型与架构设计直接影响系统的稳定性和扩展性。从订单处理的高效调度到LBS定位的精准匹配,再到支付系统的安全对接,每一个环节都需要兼顾业务需求和性能优化。例如,外卖系统开发中常见的瞬时流量高峰问题,通过Redis缓存层与分布式锁机制的结合,能够有效避免库存超卖和数据错乱;而基于SpringCloud的微服务架构,则让同城配送、优惠券核销等模块实现灵活拆分与快速迭代。

当前同城O2O市场的快速增长,为餐饮、零售、社区服务等行业提供了数字化转型的新机遇。一套经过验证的源码框架不仅能缩短开发周期,更能通过模块化设计快速适配不同业务场景。无论是初创团队需要快速验证商业模式,还是成熟企业希望升级现有系统,选择具备高可用性与弹性扩展能力的解决方案,将成为抢占本地生活服务市场的关键筹码。我们的多行业成功案例表明,合理的架构设计与持续的性能调优,能够让O2O平台在复杂业务场景中始终保持稳定输出,真正实现技术与商业价值的双赢。

常见问题

O2O平台开发需要多长时间?

开发周期取决于功能复杂度,标准化的外卖系统源码二次开发通常需2-3个月,定制化全流程开发可能延长至6-8个月,采用模块化设计可缩短30%时间。

如何选择适合的分布式架构方案?

推荐基于SpringCloud的微服务架构,支持订单、支付、LBS等模块独立部署,配合Nacos注册中心与Sentinel限流组件,可灵活应对10万级并发请求。

高并发场景下如何优化系统性能?

通过Redis集群实现热点数据缓存,结合分库分表策略分散数据库压力,使用CDN加速静态资源加载,实测可提升40%订单处理速度。

多端数据同步如何保证一致性?

采用MQ消息队列实现异步通知,配合版本号校验与补偿机制,确保APP、小程序、管理后台三端数据误差率低于0.1%。

支付系统对接要注意哪些风险?

需同时集成微信、支付宝官方SDK并定期更新,使用RSA加密传输关键数据,建议设置双重验证与异常订单自动拦截功能。

LBS定位精度如何提升到10米内?

融合高德/百度地图API的多源定位数据,通过基站/WiFi辅助定位补偿GPS偏移,结合用户历史轨迹算法校正,实测商圈场景精度达±8米。

微服务架构选型有哪些避坑建议?

避免过度拆分服务导致运维复杂化,核心服务建议使用SpringCloud Alibaba生态,非核心模块可采用轻量级Dubbo框架。

Redis缓存优化有哪些实战技巧?

采用读写分离架构,热点Key设置随机过期时间防止雪崩,大Value数据压缩存储,结合Redisson实现分布式锁保障库存同步。